WordPress Robots.txtファイルの作成と最適化する

robots.txtファイルがなくても、検索エンジンでサイトをクロール(Crawl)して索引付け(Indexing)が、このファイルを作成することをお勧め。 Googleのウェブマスターツールでサイトマップファイルを送信していない場合、Googleは、このファイルに入力されているXMLサイトマップファイルを探します。

robots.txtの ファイルは、サイトのルートフォルダに配置されます。 robots.txtの ファイルがない場合、コンピュータで robots.txtの ファイルを一つ作成FTP経由でアップロードすることができます。 (FTPを使用する方法は、こちらを参照してください。)

WordPressで動的に生成されるrobots.txt

WordPressでrobotsファイルが動的に生成されます。 example.com/robots.txtブラウザアドレス欄に入力すると、次のようなコードが出力されます。

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://example.com/wp-sitemap.xmlwp-sitemap.xmlは WordPress自動的に生成されたサイトマップです。 サイトによっては、上記のコードでは、サイトマップのラインが表示されないことがあります。 また、Yoast SEOやRank Mathのようなプラグインをインストールする場合、サイトマップはSEOプラグインで生成されるサイトマップに置き換えられます。

動的に生成されたロボットのファイルは、robots_txtフックを使用して変更が可能です。 詳細については、 WordPress 開発者向けドキュメントを参照してみてください。

また、Yoast SEOやRank Mathのプレミアムバージョンでは、このファイルを編集する機能を提供します。 」WordPress マルチサイトrobots.txtファイルを修正する「SEOプラグインでrobots.txtファイルを編集する」を参照してください。

しかし、下の説明に基づいて、このファイルを直接作成ルートフォルダにアップロードする場合には、ルートフォルダにアップロードされたファイルが優先的に適用されます。

robots.txtファイルを作成する

robots.txtの ファイルは、次のような形式で記述することができます。

すべての項目のインデックスを許可

User-agent: * Disallow:

- または -

User-agent: * Allow: /

すべての項目のインデックスを禁止

User-agent: * Disallow: /

特定のフォルダのインデックスを禁止

User-agent: * Disallow: /folder/

Googlebotが特定のファイルを除いたフォルダのインデックスを禁止するように設定

User-agent: Googlebot Disallow: /folder1/ Allow: /folder1/myfile.html

より詳しくは、 この記事を参考にしてみてください。

WordPressでrobots.txtファイルを作成する

WordPressでは、次のようにいくつかのフォルダが検索エンジンでインデックス化しないように設定することができます。

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/

必要に応じて / WP-管理/ フォルダをブロックすることができます。 私は管理フォルダをブロックするように追加したが、許可したい人もいるようです。 そして / WP-コンテンツ/plugins/ フォルダの場合は、上記はブロックするように設定したが、Googleでのページのレンダリング(処理)に必要なJavascriptやCSSをプラグインで出力することができるので、 Yoastは、ブロックしないですね。 多くの記事で / WP-コンテンツ/plugins/ フォルダもブロックすることを推奨しているが許可してもいいようです。

サイトマップは、次のような形式で追加します。

Sitemap: https://www.example.com/sitemap.xml Sitemap: https://www.example.com/post-sitemap.xml

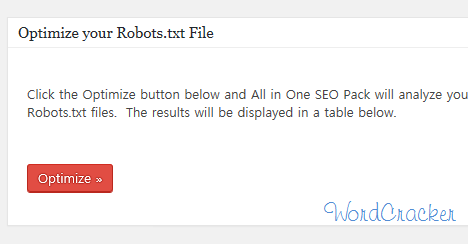

SEOプラグインをインストールした場合、robots.txtファイルを最適化するためのオプションを提供しています。 例えば、 All in One SEOをインストールした場合、ダッシュボードの左側のサイドバーで All in One SEO> Robots.txt オプションを選択すると、Robots.txtファイルを作成することができ、最適化することができるオプションも提供しています。

最適化 を押すと、All in One SEOプラグインで現在のrobots.txtファイルを分析して、変更の推奨事項を提示します。

例:

私は次のように作成しました。

User-agent: * Allow: /wp-content/uploads/ Disallow: /wp-admin/ Disallow: /readme.html Sitemap: https://www.example.com/sitemap.xml //실제 사이트맵 주소로 교체...

ルートフォルダにアップロードするときは、テキストエディタでその内容を入力し、txtファイルを作成してアップロードする必要がありますか?

PCで作成した後にアップロードしても、rootフォルダにrobots.txtファイルを作成して内容を追加してもかまいません。

こんにちは。 文を本当に丁寧によく書かれましたね。 とても素敵です〜

私 WordPressやったばかりです。 だから読んでみると、私はよく理解していないので、自分自身を見てみましょう。

私は私を書いてGoogleサーチコンソールにインデックスを要求しました。

「ページ公開ステータス:ページインデックスを作成できません:robots.txtによってブロックされています」と出てきます。

この場合、 WordPressでrobots.txtファイルを作成するには、何が本質的に入る必要があります解決ですか? お忙しいですが返信お願いします。

https://www.thewordcracker.com/?p=56307 文を参考にしてください。 WordPressでデフォルトでrobots.txtファイルを作成するので、そのまま使用しても、直接robots.txtファイルを作成して細かく調整しても構いません。 Rank MathなどのSEOプラグインでrobots.txtファイルを変更することも可能です。 「robots.txtによってブロックされています」と出てきたら、通常は無視してください。 ほとんどはインデックスにしてはいけないURLかもしれません。

こんにちは。

いつもクオリティおりすばらしい情報よく見ています! ^^一つお尋ね見たいものセンギョソヨ。

すべての検索ボットは許可するが Naverボトマンブロックしようとするんです。

ユーザーエージェント:*

Disallow:/ wp-admin /

Disallow:/readme.html

User-agent:Yeti

Disallow:/

このように作成すると、ドゥェルロンジヨ?

お忙しい時間をいただきありがとうございます。 (__)

こんにちは、シムジョンソン様。

はい。 そのまま使用すると、なりそうです。

似たような例として https://stackoverflow.com/questions/56049660/how-to-exclude-all-robots-except-googlebot-and-bingbot-with-both-robots-txt-and 文では、次のようなコードを提示しますね。

コードを作成するときにUser-agentで始まるレコード(record)の順序は重要でないとね。

検索エンジンで確実に遮断するには、robotsメタタグを使用することが望ましいことがあるようです。 次の記事を参照してください。

https://www.thewordcracker.com/blog/%EC%82%AC%EC%9D%B4%ED%8A%B8%EA%B0%80-%EA%B2%80%EC%83%89%EC%97%94%EC%A7%84%EC%97%90-%EA%B2%80%EC%83%89%EB%90%98%EC%A7%80-%EC%95%8A%EB%8F%84%EB%A1%9D-%EC%B0%A8%EB%8B%A8%ED%95%98%EA%B8%B0/

こんにちは。

robots.txtファイルは、サイトのルートフォルダに配置されます。

ここでは、ルートフォルダが正確に何であるか知りたいです。

通常、Webホスティングでftpに接続したとき、public_htmlフォルダ(Bluehost など多数)やwwwフォルダ(例: Cafe24)あるいはhtmlフォルダ(例:ダトホム)がルートフォルダになります。 場合によっては、すぐにルートフォルダに接続されるホストもあります(例えば、ガッビアーノ)。

サブドメインの場合、サブドメインのDocument Rootフォルダがルートフォルダになります。 サブドメインを指定すると、Document Rootフォルダを指定することになります。 そして Bluehost などでアドオンドメインを追加しても、アドオンドメインを追加したときに指定したDocument Rootフォルダがルートフォルダになります(「Bluehost(Bluehost)で、サブドメインを作成する/アドオンドメインを設定する"参照)。

よく見ました。 ありがとうございます。

知りたいことがありますが

robots.txtでAllow部分を以下のようにする理由はありますか?

Allow:/ wp-content / uploads /

Allow:/ < - ヨロようにすればトラブル?

私はいくつかのテストを試み、現在、上記の文で提示したように設定して使用しています。

一つの例示だけだから参考になるだけ。

こんにちは、現在Yoastを使用しており

ユーザーエージェント:*

Disallow:/ wp-admin /

Allow:/wp-admin/admin-ajax.php

このような状態ですが

Naver ウェブマスターツールでページを所有確認の過程で

「メタタグが見つからないか、 Naver 検索ロボットがサイトサーバーへのアクセスをすることができません。

ホスティングまたはサイトサーバー管理者に確認してください。

というメッセージとともに、認証がされていないんですよ。

metaタグをheadの間に入力したのにね。

寀ーはよく登録しておいた状態だ WordPressはうまくいかがないんですよ。

もしかしたら、この過程を経ましたか?

WordPressを知っている行こう Naver 検索をすると、ここが頻繁に露出がんですよ。

こんにちは?

headの間に追加されたメタタグは削除してYoast SEOを使用して、メタタグを設定してみてください。

次の記事を参考にしてください。

https://www.thewordcracker.com/basic/%EA%B5%AC%EA%B8%80%EC%9D%B4%EB%82%98-%EB%84%A4%EC%9D%B4%EB%B2%84%EC%97%90-%EA%B2%80%EC%83%89%EB%90%98%EB%8A%94-%EC%82%AC%EC%9D%B4%ED%8A%B8%EC%9D%98-%EC%A0%9C%EB%AA%A9-%EB%B3%80%EA%B2%BD/

それでもうまくいかないと、プラグインをすべて無効にした後にテストしてみてください。

使用しているWebホスティングはどこですか?

場合によっては、Webホスティングの問題であることもあります。

(Cafe24の場合は、Webファイアウォールを無効にした後、テスト状態みることもあるようです。)

私も今同じ理由で昼と夜に苦しんでいます。

もし解決したらどうやって共有することができますか...

サーバー上 Naverボット(Yeti)をブロックしている可能性があります。 Cafe24 同じ場合は、ファイアウォールを無効にしてください。 ホスティングに連絡して Naverボットをブロックしていないことを確認してみますか?

こんにちは良い文ありがとうございます。 見回すと良い文が多く驚きました。 本当にありがとうございます。

お尋ね見たいことが一つありますが、私は現在、Yoastを使用しています。 基本robots.txtで

ユーザーエージェント:*

Disallow:/ wp-admin /

Allow:/wp-admin/admin-ajax.php

このように書かれているが、この場合には、adminを除くすべてのページにクロールを許可することを意味でしょうか?

ありがとうございますㅠㅠ!

こんにちは?

/ wp-admin /はできませんが/wp-admin/admin-ajax.phpは許容するという意味ですね。

ちなみに私は、robots.txtファイルを作成し、以下の内容を追加しました。

User-agent: *Allow: /wp-content/uploads/

Disallow: /wp-admin/

Disallow: /readme.html

Sitemap: http://www.example.com/sitemap.xml //사이트맵 주소...こんにちは? 良い情報よく見ました。

気になる点がありますが、投稿物の上部に

1。 robots.txtファイルを作成する

robots.txtファイルは、次のような形式で記述することができます。

「すべてのアイテムのインデックスを許可」

User-agent:* Disallow:

또는

ユーザーエージェント:*許可:/

「すべてのアイテムのインデックスを禁止」

でDisallowとAllowのハングル説明が互いに入れ替わっことないですか? Allowができるように、Disallowが不可だが、ミスが私のようです。 先生文を見てrobots.txtを修正しているが発見して文余すです。 良い文章ありがとうございます:)

こんにちは?

早朝なのに私のブログを訪問してくださってコメントを残しましたね。

上記の内容は、適合、ちょうど広告バナーので混同にされていますね。

User-agent: *Disallow: /

-->この場合、サーバーからすべてのロボットを除外

User-agent: *Disallow:

-->この場合、すべてのロボットのフロントアクセスを許可する

もっと詳しく http://www.robotstxt.org/robotstxt.html 文を参照してみてください。